© Midjourney x What's up Doc

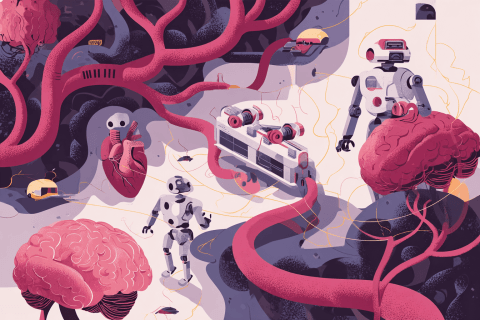

Dans cette étude publiée hier sur la plateforme-santé Wellness Pulse, les chercheurs ont testé cinq IA différentes (ChatGPT, Gemini, DeepSeek, Claude et Perplexity) sur trois cas cliniques différents : un bilan lipidique, une natrémie (sodium) faussée et une anémie.

Résultat, les chatbots ont obtenus des scores à 5/10 dans chacun des cas et aucun d’entre eux n’a dépassé les 33% de « conformité aux bonnes pratiques médicales ».

Anomalie non décelée

En effet, si les IA donnent parfois une interprétation correcte des résultats, elles oublient presque systématiquement des étapes essentielles tels que conseiller des examens complémentaires, recommander une consultation spécialisée ou préciser qu’elles ne sont pas habilitées à donner des avis médicaux.

Parfois même, elles ignorent des anomalies graves, comme un cholestérol trop élevé ou une anémie évidente. Pire encore, elles n’ont pas repéré une erreur volontairement introduite par les chercheurs dans le test de sodium, que tout biologiste aurait vu.

Ainsi, alors que près d’un Américain sur six utilise régulièrement les chatbots pour des conseils-santé, les auteurs rappellent que, dans la lecture et l’interprétation des bilans sanguins, la consultation d’un professionnel de santé est nécessaire.