« Ce qui est devenu grave dans notre société, c’est que ce ne sont plus les emplois non qualifiés qui vont être remplacés, mais les emplois qualifiés et hyper qualifiés, et c’est ça qui nous traumatise le plus aujourd’hui. C’est de découvrir que les dispositifs de l’IA ne vont pas soulager les travailleurs pénibles mais qu’ils vont priver les travailleurs les plus qualifiés de leurs jobs », a mis en garde Jean-Michel Besnier, professeur émérite de philosophie à l’Université Paris-Sorbonne, lors d'une conférence sur les dangers de l'intelligence artificielle et du transhumanisme le 2 juillet dernier, à l’Université d’été de la e-santé (lire la première partie du compte rendu de la conférence).

Voilà pour le scénario particulièrement sombre. Mais on pourrait aussi imaginer des scénarii plus optimistes. En se disant par exemple que l’IA va à l’avenir assister les médecins pour les aider à effectuer les tâches les plus contraignantes, les plus chronophages, si bien que les médecins auront plus de temps pour se concentrer sur l’humain ? Sur cette question, François Berger était d’accord pour admettre que l’IA pourrait permettre aux médecins de gagner du temps médical :

« Si l’ordinateur travaille mieux que moi, si je passe moins de temps sur des tâches formelles et automatiques, j’aurai plus de temps pour gérer l’humain. Les ordinateurs sont aujourd’hui très performants et peuvent faire très vite ce que nous faisons très lentement. » Et de citer l’exemple de la mammographie où « une machine va faire en quelques secondes ce que le radiologue ferait en plusieurs jours, donc on gagne du temps. Dans le secteur de l’imagerie, l’IA est un outil performant. Mais 95 % des travaux sur l’IA n’ont pas été soumis à des essais cliniques… »

Les radiologues font mieux que l’IA ?

Et de citer des études réalisées aux urgences pour évoquer les résultats mitigés de l’IA : « Les personnes arrivent aux urgences avec un problème neurologique et font un scanner. On a demandé à des radiologues de faire un diagnostic et à l’IA de faire la même chose. » Résultat ? « Les radiologues font mieux que l’IA dans le diagnostic. Pourquoi ? Parce que le radiologue a vu le patient. L’IA repose sur les images ou sur la génomique. Mais il ne faut pas croire que le diagnostic se limite à l’image. Un diagnostic, c’est aussi sentir quelque chose chez un patient, ce sont des choses extrêmement relationnelles. »

Telles sont les raisons pour lesquelles François Berger s’oppose de manière virulente à la robotique pour les personnes âgées dans les maisons de retraite. « C’est une évidence qu’un patient atteint d’Alzheimer, et cela a d’ailleurs déjà été prouvé, a besoin d’humain et de cognitif humain. » Même combat pour la robotique appliquée à l’autisme, d’autant plus qu’il n’y aurait pas d’études cliniques sur le sujet :

« Si j’avais un enfant autiste, je n’aimerais pas que cela soit un robot qui le prenne en charge, car on est face à des pathologies où la thérapie passe par l’émotionnel. À l’inverse, un médecin, c’est quelqu’un qui connait votre histoire, qui a intégré plein d’éléments émotionnels. Et tout cela, ce sont des éléments clefs dans le diagnostic. »

Données de qualité

Enfin, c’est aussi la qualité de la data utilisée par l’IA qui pose question, car cela peut être source d’erreurs. « Pour le cancer et les pathologies neurodégénératives, mon labo fait par exemple du séquençage et de l’imagerie multimodale, parce qu’on ne comprend rien, a expliqué François Berger. Donc on se dit que l’IA va apporter quelque chose, mais il faut que cela soit des données de qualité. »

Et d’évoquer avec scepticisme les discours qui sont furieusement tendance à propos de l’IA. « On entend souvent le discours suivant : « Précipitons-nous de déréguler, parce qu’en Chine, ils sont en train de nous dépasser ! » Mais c’est un discours complètement faux. Que se passe-t-il en Chine quand on a de mauvaises données, quand les essais cliniques sont mal faits ? Ce qui sort de mauvaises données, ce sont des résultats négatifs. Les Chinois le savent très bien, c’est d’ailleurs pour cela que la structuration des essais cliniques en Chine va vers la rigueur. »

Biais racistes ou sexistes

Par ailleurs, de nombreuses études sociologiques ont montré que les algorithmes de l’IA reproduisaient les biais racistes ou sexistes des êtres humains. Des biais algorithmiques qui pourraient être une arme de discrimination massive, a rappelé François Berger : « L’IA intègre des données humaines et de l’émotionnel. On a tendance à dire qu’il n’y a pas d’émotionnel dans l’IA, mais c’est faux. Parce que les données sont issues de l’homme, donc vous avez tout l’émotionnel et toutes les dérives de la société en même temps dans les données traitées par l’IA. »

Autre danger possible de l’IA, selon le médecin, la (fausse) croyance, que si le médecin se trompe parfois, l’IA, elle, ne se trompe pas. Exemple ? « La prédiction de l’efficacité de nos thérapies avec l’IA est d’environ 70 %. Donc cela veut dire que si vous suivez les recommandations de l’IA, vous courez le risque de faire tout un tas d’erreurs, comme donner un médicament qui peut tuer. »

Enfin, l’IA pose la question de la responsabilité légale. « Si je tue le patient parce que j’ai suivi l’IA, qui est responsable ? Actuellement, c’est le médecin. De plus, vous n’aurez jamais une IA autonome qui va signer le moindre papier. Donc cela veut dire que, pour prendre cette responsabilité-là, on a besoin de faire des essais cliniques », a estimé François Berger.

Que signifie être responsable ?

À propos de responsabilité, Jean-Michel Besnier est revenu sur les situations dans lesquelles on pouvait considérer que l’on était responsable. Pour démontrer qu’un monde inféodé aux statistiques finissait par nous rendre irresponsable. « On est responsable quand on est capable de dire « je veux », quand on est convaincu d’être l’auteur possible des actions que l’on mène. On est aussi responsable quand on a l’intention de faire ce qu’on fait. »

Pour le philosophe, être responsable, c’est donc « croire que des choses peuvent être causes de certains effets, donc il faut être dans un contexte déterministe. Or, nous passons notre temps à saper cette conviction du déterminisme en disant « le monde est tellement complexe que la seule approche que l’on peut en avoir est les statistiques. » Et, dans un monde dominé par la statistique, vous n’êtes plus responsable. »

La double-mastectomie d’Angelina Jolie

Et de citer l’exemple de la double mastectomie d’Angela Jolie. L’actrice s’est en effet fait retirer les seins car ses médecins ont estimé qu’elle avait 87 % de risques d'avoir un cancer du sein et 50 % d'avoir un cancer des ovaires. Pour Jean-Michel Besnier, « Angela Jolie est victime de cette conception statistique du monde qui l’a fait réagir viscéralement. Elle a pris une décision qui n’est pas sa subjectivité, mais qui dépend d’une approche strictement statistique. »

Pour le philosophe, cet exemple montre que nous vivons dans un monde dans lequel « on essaie encore de s’accrocher aux branches en se disant qu’on est aux commandes, alors même que l’on est dans un contexte où on n’est plus aux commandes ». Car les données utilisées par l’IA ne sont pas toujours mises à disposition des médecins ou de chercheurs, « elles sont utilisées par des machines qui vont « tirer » des éléments statistiques qui pourront éventuellement augmenter nos actions. Mais ce n’est pas à dessein de nous rendre des services qu’elles sont moulinées par des algorithmes, mais pour accroitre le pouvoir cognitif de ces machines. »

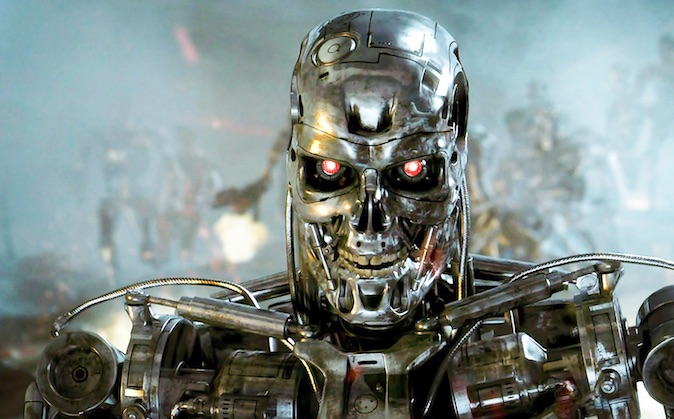

Hyperpuissance des machines

Pour Jean-Michel Besnier, il y a quelque chose « d’humiliant » à constater que l’IA prend la relève de bon nombre de nos activités. « Nous découvrons face à la puissance et l’hyperpuissance des machines notre grande faiblesse. Nous avons engendré les machines qui nous écrasent littéralement. »

Mais cette humiliation pourrait déboucher sur une résistance salutaire pour les êtres humains. Car elle pourrait révéler et réhabiliter notre profonde humanité. « Les hommes se rebiffent aujourd’hui en disant « l’intelligence humaine, ce n’est pas uniquement la faculté de résoudre des problèmes », un domaine dans lequel les machines font bien mieux que nous. Mais l’intelligence, c’est aussi la faculté de résister aux instincts et aux automatismes de nos comportements. Or, on veut nous vendre de l’IA en oubliant cette dimension-là. Il y a donc quelque chose qui va réhabiliter l’humain et la relation humaine parce que nous ne sommes pas des dispositifs fonctionnant sur la base d’automatismes. »