© Midjourney x What's up Doc

Les chiffres donnent le ton : plus de 230 millions de requêtes hebdomadaires liées à la santé sont adressées à ChatGPT. Un volume que son éditeur ne peut plus ignorer. OpenAI a donc officialisé ce qui était déjà une pratique diffuse : l’utilisation de son chatbot pour comprendre des symptômes, des résultats d’examens ou préparer une consultation médicale.

Avec ChatGPT Health, l’entreprise ne prétend pas transformer son IA en médecin. Elle insiste au contraire sur une posture d’accompagnement : « Il n’a pas pour but d’établir un diagnostic ou de traiter un problème de santé. Il vous aide plutôt à répondre à vos questions quotidiennes et à comprendre l’évolution de votre état de santé au fil du temps (…) afin que vous soyez mieux informé et préparé aux discussions médicales importantes ». Le message, sur le papier, est clair : l’outil se positionne en amont et en aval de la consultation, pas à sa place.

Un espace cloisonné pour des données sensibles

La principale nouveauté n’est donc pas tant fonctionnelle que structurelle. ChatGPT Health est conçu comme un espace distinct, doté de sa propre mémoire et d’un stockage séparé des autres conversations. Les données de santé, issues d’objets connectés, d’applications ou de dossiers médicaux, y sont isolées, avec la promesse qu’elles ne serviront pas à l’entraînement du modèle.

Cette segmentation répond à une double contrainte : rassurer des utilisateurs de plus en plus conscients de la sensibilité de leurs données, et anticiper les exigences réglementaires. Sans surprise, l’outil n’est pour l’instant accessible qu’en dehors de l’Espace économique européen. La France, une nouvelle fois, reste à l’écart.

Des promesses… et des limites bien réelles

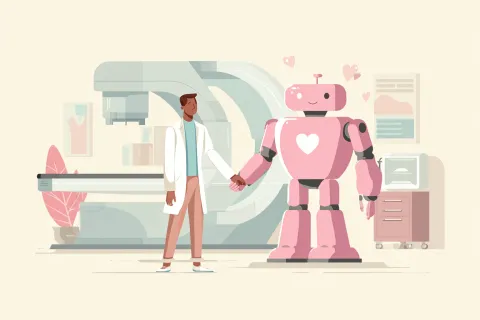

OpenAI multiplie les garde-fous discursifs, et ce n’est pas anodin. Les exemples d’erreurs existent, parfois lourdes de conséquences. L’entreprise rappelle que son IA peut se tromper, et qu’elle ne remplace en aucun cas l’expertise médicale. Pour les médecins, le risque est connu : voir arriver en consultation des patients « pré-informés », parfois rassurés à tort ou inquiétés inutilement.

L’enjeu n’est donc pas de nier ces usages, mais de les intégrer dans la relation de soin. ChatGPT Health est pensé comme un outil de clarification et d’organisation : comprendre une prise de sang, préparer des questions, structurer un parcours de soins. Autant de tâches périphériques qui, bien utilisées, peuvent fluidifier l’échange médecin-patient… ou le compliquer si elles reposent sur une confiance excessive dans l’outil.

Anthropic cible plus frontalement les professionnels

Quelques jours après OpenAI, Anthropic a dévoilé Claude for Healthcare. Changement de posture. Ici, la cible n’est plus prioritairement le patient, mais les acteurs du système de santé : assureurs, établissements, chercheurs. L’IA est intégrée dans des flux de travail conformes aux normes HIPAA, avec des connecteurs vers des bases de codification, de couverture ou d’annuaires de prestataires.

Les usages annoncés sont très opérationnels : automatisation des autorisations préalables, préparation de dossiers, coordination des soins, résumé de documents. Anthropic promet que les données ne sont ni stockées ni utilisées pour améliorer les modèles, un argument désormais central dans ce secteur.

Un partenaire de recherche

Anthropic va plus loin avec Claude for Life Sciences, orienté recherche et R&D. Connexions à PubMed, bioRxiv ou ClinicalTrials.gov, assistance à la rédaction de protocoles, extraction de résultats, analyse de données : l’IA se positionne comme un outil de productivité scientifique. Une stratégie de spécialisation assumée, là où OpenAI privilégie un modèle unifié, sans connecteurs métiers profonds.

Ces annonces marquent une rupture : les grands modèles ne se contentent plus d’être des outils généralistes. Ils s’installent dans des espaces dédiés, avec des promesses de conformité et de cloisonnement. La santé devient un marché à part entière, à fort volume et forte valeur.

Pour les médecins, le message est ambivalent. D’un côté, ces outils peuvent améliorer la compréhension des patients, réduire certaines frictions et alléger des tâches administratives. De l’autre, ils renforcent la nécessité d’un rôle clé : celui de tiers de confiance, capable de remettre du sens, du contexte et de la nuance là où l’IA fournit surtout des réponses organisées, mais sans responsabilité clinique.